Dataiku

Beyond Data コラム

【No.1】データ分析プラットフォームとは?基本から選定・導入の秘訣まで完全ガイド

|

|

データ分析プラットフォームとは、企業や組織が多様なソースからデータを収集・統合・加工し、分析やAI活用に展開するための基盤です。これは単なるツールではなく、データドリブン経営や業務を実現する「仕組み」そのものといえます。

目次

データ分析プラットフォームの重要性

現代のビジネスにおいて、データ分析プラットフォームの重要性はますます高まっています。組織が迅速かつ的確に意思決定を下すには、信頼性の高いデータに容易にアクセスでき、可視化や分析を行える環境が不可欠です。

このような環境を整えることで、業務プロセスをデータで可視化し、分析を加えることが可能となります。これにより、これまで気づけなかった非効率な業務や新たなビジネスチャンスを発見できるようになります。たとえばマーケティング領域では、顧客データを統合して分析することで、パーソナライズされたキャンペーンの実施や顧客生涯価値(LTV)の予測が可能となり、結果としてマーケティングROIの向上につながります。

さらに、データ分析プラットフォームの導入は、組織内に散在していたデータや知識を一元化し、これらを全社で共有できるようにする効果ももたらします。これにより部門間の壁を越えた協働が促進され、組織全体としての意思決定スピードやイノベーション創出力が向上します。

加えて、従来の月次や週次のレポート作成では、現代のビジネススピードに対応することが困難です。市場の変化をいち早く察知し、競争優位を確立するためには、リアルタイムに近い形でデータを分析・活用できる環境が欠かせません。こうした観点からも、データ分析プラットフォームは今や企業にとって戦略的に不可欠な存在となっています。

データ分析プラットフォームの主な機能

データ分析プラットフォームは、データを活用した意思決定を支えるために、様々な機能を備えています。ここでは特に重要となる機能をご紹介します。

データ収集と統合

データ分析の第一歩は、多様なソースからのデータを収集することです。代表的なデータソースには以下のようなものがあります。

| API |

各種サービスが提供するAPI

|

|---|---|

| データベース |

MySQL、PostgreSQL、Oracle、SQL ServerなどのRDBMS

|

| ファイル |

CSV、Excelなどの形式でエクスポートされたデータ

|

| ストリーミングデータ |

IoTデバイスやWebサイトのクリックストリームなどリアルタイムデータ

|

| データレイク |

構造化・非構造化を問わず大量データをそのまま格納し、その後の分析や機械学習に活用できるストレージ環境

|

データ統合では、多様なデータソースから収集した異なるデータを一貫性のある形式に変換し、一元管理します。

データ加工と可視化

収集した生データは、そのままでは分析に適さない場合がほとんどです。そのため以下のようなデータ加工を要します。

| データクリーニング |

欠損値処理、異常値の検出・除去、重複データの削除

|

|---|---|

| データ変換 |

データ形式の統一、単位の変換、カテゴリ値のエンコード

|

| データ整形 |

分析目的に合わせたデータ構造への再編成(ピボット、アンピボットなど)

|

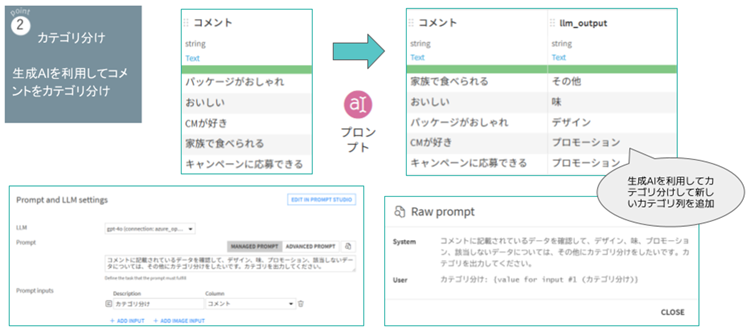

データ収集と統合の作業は、GUI上で直感的に操作できるだけでなく、PythonやSQLなどのコードを組み合わせた柔軟な処理ができなくてはなりません。また、近年では生成AI機能による自然言語でのデータ加工を実現できるソリューションもあり、ニーズに合ったデータを短時間で構築できます。

|

図1:自然言語によるデータ加工(Dataikuの例) |

データ分析と可視化

データは加工と可視化を経て、以下のような分析に用いることができるようになります。

| 記述統計 |

データの分布や傾向を要約(平均、中央値、標準偏差など)

|

|---|---|

| 探索的データ分析(EDA) |

可視化を用い、パターンや異常を発見

|

| 推計統計 |

標本データから母集団の特性を推測

|

| 機械学習 |

予測モデル構築、クラスタリング、異常検知など

|

分析の目的は多岐にわたり、過去の実績理解(レトロスペクティブ分析)、現在状況把握(リアルタイム分析)、未来予測(予測分析)など、時間軸に応じた分析アプローチが必要です。

こうして得られた分析結果は、可視化やレポートとして意思決定者に届けられ、ビジネス改善や戦略立案に活用できるようになります。

データ分析プラットフォームを導入するメリット

データ分析プラットフォームは、単なる「データを参照するためのツール」ではなく、組織全体の「データ活用力」そのものを底上げする基盤です。データを一箇所に集約し、誰もが簡単に分析・活用できる環境を整えることで、スピード感のある持続的な成長を実現するための核心的なインフラとしての価値があります。

迅速な意思決定の実現

データ分析プラットフォームを活用する最大のメリットは、意思決定のスピードを大幅に高められることです。

従来は、各部門からデータを個別に収集し、Excelで手作業集計やレポート作成を行っていたため、最新データの把握や分析に時間を要していました。

データ分析プラットフォームでは、複数のデータソースから情報を自動で収集・統合し、リアルタイムに近い形で可視化・分析を実施できます。これにより、現場の状況をすぐに把握し、迅速に判断を下せるようになります。

このように、データ分析プラットフォームは意思決定のスピード向上、業務効率化、コスト削減、さらには生産性向上に直結する重要なツールとなります。

データの一元管理がもたらす効率化

多くの組織では、顧客情報や販売データなどの重要なデータが部門ごとのシステムやサイトに分散し、重複や矛盾が生じやすい状況にあります。このような課題を解決するためには、データ分析プラットフォームを活用してデータを一元管理することが有効です。

データの一元管理によるメリットは以下の通りです。

| 効率的なデータアクセス |

必要なデータをすぐに発見できる

|

|---|---|

| データの整合性確保 |

組織間でデータの解釈がぶれない

|

| 関連するデータの結合 |

別々のデータをつなげて新しい洞察が得られる

|

実務では、データ分析プラットフォームによる一元管理により、報告書や資料作成にかかる時間を大幅に削減できる事例が多く報告されています。これにより、分析や意思決定のスピードが向上し、組織全体の効率化と意思決定の質向上につながります。

コスト削減とROIの向上

データ分析プラットフォームの導入は、短期的にはコストがかかるものの、中長期的には大きなコスト削減効果とROIの向上が期待できます。

GartnerやForresterなどの調査レポートでは、データ分析基盤のROIは比較的短期間(1〜2年以内)に出るケースが多いと報告されています。理由は、分析基盤そのものが「効率化」「工数削減」「可視化による意思決定改善」など、効果が数値化しやすい領域だからです。

主なコスト削減の要因

- データ収集・加工の自動化による人件費削減

- クラウド利用による従量課金制でのコスト最適化

- データ重複排除によるストレージ費用削減

- 問題の早期発見による機会損失の抑制

さらに、レポート作成時間の短縮や誤った意思決定の減少、新規ビジネス創出などをKPIとして効果を測定することで、ROIを明確に可視化できます。

これにより、迅速な市場対応や顧客ニーズの把握が可能となり、競争力とビジネス価値の持続的な向上につながります。

データ分析プラットフォーム導入のステップ

データ分析プラットフォームを導入する際に大切なのは、単に最新のツールを使うことではありません。組織の課題を解決し、意思決定をより迅速に、より正確に下すための手段として活用することが目的です。まずは導入する理由を明確にして、方向性を定めることから始めなくてはなりません。

導入目的の明確化

まず、「なぜ導入するのか」を明確にすることが重要です。目的が曖昧なままだと、プラットフォーム選定や導入後の効果測定がうまくいきません。

目的設定のプロセス

- 1.ビジネス課題や機会を洗い出す

- 2.データ分析で解決したい問題を具体化する

- 3.期待効果とKPI(重要業績評価指標)を設定する

- 4.関係者間で合意を形成する

この時他社事例も参考になりますが、そのまま真似するのではなく、自社の状況に合わせてカスタマイズすることが重要です。

導入目的を明確にする際は、以下の観点で整理すると効果的です。

- どの意思決定プロセスを改善したいか

- 現在どのようなデータ活用上の課題があるか

- 誰がどのような恩恵を受けるか

- 効果をどう測定するか

目的が明確になれば、自社に合った機能の見極めや、導入範囲・優先順位の決定、段階的な拡張計画も立てやすくなります。

適切なプラットフォームの選定

導入目的が明確になったら、次は自社に最適なプラットフォームを選定します。市場には多くの選択肢があるため、目的や環境に合うかを見極めることが重要です。

選定のステップ

| 必須機能の洗い出し |

目的達成に不可欠な機能を明確化

|

|---|---|

| 候補の絞り込み |

技術スタック・予算・スキルに適合するものを選定

|

| 評価と比較 |

デモやトライアルで使い勝手や性能を確認

|

| コストと効果の比較 |

料金体系を理解し、ROIを試算

|

選定時に考慮すべき要素

| 専門人材の有無 |

不足していればマネージド型が有効

|

|---|---|

| データ規模 |

現状・将来のデータ量に対応できるか

|

| 統合性 |

既存システムやツールと連携可能か

|

| ユーザビリティ |

利用者にとって使いやすいか

|

| 技術要件 |

クラウド/オンプレ、連携可能なデータソース、スケーラビリティなど

|

導入や運用の難易度、サポート体制も含めて総合的に評価することで、長期的な成功につながります。

運用体制の構築

プラットフォームを導入しても、適切な運用体制がなければ十分に活用できません。継続的な活用を促すために、組織的な仕組みづくりが重要です。

運用体制構築のポイント

| 役割と責任の明確化 |

データ管理者・分析者・ビジネスユーザーなどの役割を定義

|

|---|---|

| ルールとガバナンス策定 |

アクセス権限、品質管理、セキュリティポリシーを整備

|

| 教育・トレーニング |

ユーザー層に合わせた研修やマニュアルを提供

|

| 継続的な改善 |

利用状況の把握とフィードバックによる定期的な見直し

|

標準化された利用ルールを整備することで、データの一貫性や分析品質を維持できます。

また、社内に経験豊富な人材が不足している場合は、初期段階で外部の専門家を活用することで、導入・定着をスムーズに進められます。

データ分析プラットフォーム導入時の課題

データ分析プラットフォームの導入は多くのメリットがありますが、同時にいくつかの課題にも直面します。導入をスムーズに進め、成果を上げるには、まずこれらの課題を理解しておくことが重要です。

データの統合と整合性の確保

データ分析プラットフォーム導入において、最も一般的な課題の一つが複数のソースからのデータ統合と、その整合性の確保です。企業内には、様々な形式やシステムで個別に保存されたデータが存在し、これらを組み合わせて一貫性のある分析基盤を構築するには、適切な計画と実行が必要です。

主な課題と解決策

| データ形式の不一致 |

ETLツールで統一

|

|---|---|

| データ品質の問題 |

クレンジングで欠損値・異常値を対応

|

| データの重複 |

重複排除で一意化

|

| リアルタイム性の要求 |

ストリーミング処理で対応

|

また、部門間でデータを共有する文化を作ることも重要です。これにより、新たな洞察が得やすくなります。

セキュリティとプライバシーの問題

分析プラットフォームには機密データや個人情報が集まるため、セキュリティとプライバシーの確保は不可欠です。

主な対策

- アクセス制御、データ暗号化、監査ログ

- 個人情報はマスク化や仮名化で保護

- 登録時点からセキュリティを考慮した設計

これにより、後からの対応コストを減らし、堅牢な体制を構築できます。

運用の継続性とサポート体制

データ分析プラットフォームは、導入して終わりではありません。継続的な運用と保守が不可欠です。特に、データソースの変化やビジネス要件の変更に合わせて、プラットフォーム自体も進化させていく必要があります。

ポイント

| サポート体制 |

ベンダーやITチームから支援を確保

|

|---|---|

| 知識管理 |

ドキュメントやナレッジで属人化防止

|

| モニタリング |

異常を早期検知し対応

|

| 定期メンテナンス |

チューニング、バックアップ、バージョンアップを計画的に実施

|

まとめ

データ分析プラットフォームは、企業のデータ活用を加速させる基盤として、ますます重要性を増しています。そして、近年はAIや機械学習との統合、クラウド環境との親和性が特に重視されており、このような要件を満たすプラットフォームが、長期的に企業の成長を支える存在となります。

Dataikuをはじめとする先進的なデータ分析プラットフォームでは、ビジネス部門とデータサイエンティストが協働できる仕組みや、自動機械学習(AutoML)、自己学習リソースなどが提供されています。これらは組織全体でのデータ活用を推進し、成果を出しやすくする上でとても有効です。

最終的には、自社のデータを用いて検証し、自社にとって最適な選択肢を見極めることが成功の第一歩となるでしょう。

※本記事の内容は公開時点(2025年11月17日)のものです。

「Beyond Data コラム」記事一覧

お問い合わせ

Dataikuについてのご質問やご導入に向けたご相談は、以下のフォームよりお気軽にお問い合わせください。